La adopción de la inteligencia artificial crece y, con ello, un riesgo poco conocido para la mayoría: la fuga de los datos que le damos a la inteligencia artificial.

Efectivamente, la adopción de la inteligencia artificial es masiva e innegable. “En 2025, ChatGPT supera los 700–800 millones de usuarios semanales, según datos recientes reportados por la prensa especializada a partir de declaraciones de OpenAI», explica Matias Hilaire, CEO de The App Master, compañía argentina que crea soluciones tecnológicas para startups, pequeñas y medianas empresas.

Lo que pocos saben es que lo que se comparte ahí no es privado, sino que las inteligencias artificiales utilizan los datos que se vuelcan para seguir entrenándose. En otras palabras, las conversaciones con ChatGPT, Gemini y otras versiones gratuitas o personales de inteligencias artificiales pueden usarse para mejorar el modelo; y no solo eso, sino que esto funciona por defecto, salvo que el usuario lo desactive manualmente en las configuraciones.

Ahora bien, no todos los modelos funcionan igual, ya que las versiones empresariales o de trabajo no utilizan los datos para entrenamiento y existen acuerdos formales que protegen la información. En palabras de Juan Pablo Cosentino, profesor asociado y director académico del área Operaciones y Tecnología de IAE Business School, la escuela de negocios de la Universidad Austral: “Hay una regla simple que aplica en este ámbito: si es gratis, deberías saber que nada es gratuito, por lo tanto, asumí que se entrena con tus datos».

El especialista explica que, aunque los modelos no “cuenten tus secretos”, pueden “memorizar” fragmentos raros o únicos de texto. “Si otro usuario hace una pregunta muy similar, existe una pequeña posibilidad de que aparezca algo parecido a lo que vos escribiste”, agrega.

¿Cuál es el peligro de esto? Si la IA está ampliamente extendida en todo el mundo y se utiliza en contextos de trabajo, existe un gran riesgo de difundir información laboral sensible. Y, según los expertos, esto ya está ocurriendo. “La adopción masiva de IA generativa disparó un fenómeno silencioso: empleados y directivos pegan texto sensible (contratos, planillas salariales, código propietario, datos confidenciales de la empresa, estrategias de marketing) en chats públicos o cuentas gratuitas. La productividad crece, pero también el riesgo de fuga de datos y de incumplimientos normativos», explica Hilaire.

Y aporta datos que evidencian cómo la IA ingresó en las empresas por “la puerta de atrás”: un informe de Microsoft (octubre 2025) halló que 71% de los trabajadores usan herramientas de IA no aprobadas por su compañía. Si a eso se suman otros números, como un estudio difundido por TechRepublic, según el cual el 77% de los empleados comparten datos sensibles con ChatGPT u otras inteligencias artificiales, el resultado de la ecuación se torna especialmente crítico.

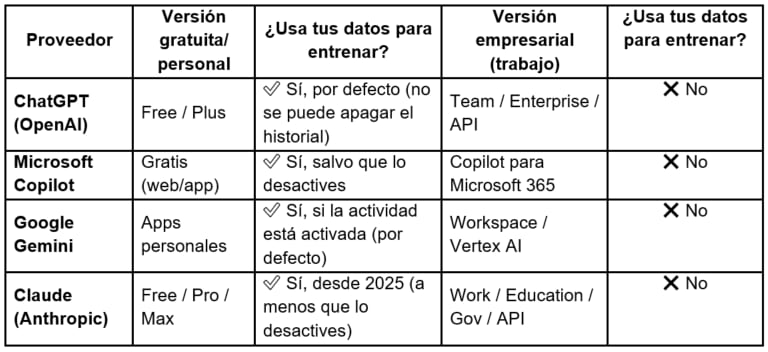

¿Cuáles son los modelos o versiones de inteligencia artificial que usan tus datos?

Sergio Pernice, director de Ingeniería en Inteligencia Artificial de la UCEMA, explica que los proveedores aclaran en los términos y condiciones si usan o no los datos del usuario para entrenar modelos. “En «Términos de uso», «Contenido» y «Nuestro uso del contenido» de ChatGPT personal (Gratis/Plus/Pro) especifican que pueden usar tu contenido «para ofrecer, mantener, desarrollar y mejorar nuestros Servicios», y que podés optar por no participar (opt out)“, detalla Pernice.

Cosentino agrega que también se detalla en lugares como “Política de Privacidad”, “Configuración de Datos”, “Centro de Ayuda”, “Preguntas Frecuentes” o “Acuerdos para empresas (DPA/EDP)” en el caso del mundo corporativo. Además, precisa cuáles son las inteligencias artificiales y sus versiones que utilizan los datos personales para entrenar la inteligencia artificial:

- ChatGPT: la versión gratuita o personal (free/plus) los usa por defecto y no se puede apagar el historial. Su versión empresarial (Team/Enterprise/API) no lo utiliza.

- Microsoft Copilot: su versión gratuita (web/app) también emplea los datos, salvo que el usuario los desactive. Su modelo Copilot para Microsoft 365 no.

- Google Gemini: sus apps personales hacen uso de los datos de los usuarios, si la actividad está activada (que por defecto lo está), pero en su versión empresarial Workspace/Vertex AI no los emplea.

- Claude (Anthropic): sus versiones gratuitas Free/ Pro/ Max desde 2025 que utiliza los datos del usuario, a menos que los desactive. Sin embargo, su versión Work/Education/Gov/API no lo hace.

Ahora bien, aunque solo las versiones gratuitas utilizan los datos, Hilaire aclara que menos del 10% de los usuarios de plataformas como ChatGPT utilizan una cuenta paga. “Es clave que las organizaciones definan políticas claras sobre el uso de la IA y se aseguren de que sean cumplidas. Las plataformas que se utilicen deben ser validadas por equipos”, agrega Hilaire.

¿Qué información no deberías compartir nunca con la IA?

Los especialistas coinciden en que la solución a este problema está en elegir planes empresariales con garantías explícitas de no-entrenamiento sobre datos de clientes, retención controlada y cumplimiento. Además, Hilaire aconseja diseñar guardrails (barandas de seguridad) que gobiernen entradas, salidas, comportamiento del modelo y operación.

Pernice agrega qué información es prudente no compartir con la inteligencia artificial, en caso de que el usuario no esté en una versión empresarial:

- Identificadores personales y de contacto.

- Datos “especialmente sensibles” como de salud, genética, biométricos (rostro/voz/huella), opiniones políticas, creencias religiosas/filosóficas, etc.

- Datos de menores.

- Credenciales y secretos de seguridad.

- Números de tarjeta, CVV, cuentas bancarias, CLABE/CBU, entre otros del estilo.

- Información legalmente protegida o privilegiada.

Otros especialistas agregan que no es bueno evitar compartir información del ámbito laboral, como estrategias comerciales de una empresa, precios internos o productos aún no anunciados.

Cosentino agrega algunos hábitos simples que pueden ayudar:

- Desactivá el entrenamiento del modelo (si tu versión lo permite). Buscá en configuración opciones como “Improve model for everyone” o “Model training”.

- Usá “chats temporales” o modo incógnito cuando hables de temas delicados. Esas conversaciones no se guardan.

- Aplicá la regla de oro: “No pegues en el chat nada que no mandarías por mail sin encriptar”.

- Anonimizá la información: si necesitás compartir un documento real, cambiá nombres o datos sensibles por etiquetas genéricas, como “empresa” o “monto”.

- Borrá el historial regularmente: de esta forma, evitás que tus datos queden guardados de forma indefinida.